Der Mythos der Grundlagenforschung

Treibt die wissenschaftliche Forschung die Entwicklung von Innovationen voran? Nicht besonders häufig, argumentiert Matt Ridley: Die technologische Entwicklung verfügt über eine Eigendynamik, die nur wenig mit den Abstraktionen eines Forschungslabors zu tun hat.

Innovation lässt sich auf mysteriöse Weise nur schwer diktieren. Technologie scheint sich durch eine Art unaufhaltsamen, evolutionären Fortschritt weiterzuentwickeln, den wir wahrscheinlich nicht aufhalten – und auch nicht wesentlich beschleunigen können. Und darüber hinaus resultiert er nicht so sehr aus den Erkenntnissen der Wissenschaft heraus. Die meisten technologischen Durchbrüche stammen von tüftelnden Technikern, und nicht von Forschern, die ihren Hypothesen nachgehen. So ketzerisch dies auch klingen mag, die „Grundlagenforschung“ verfügt nicht annähernd über die Produktivität hinsichtlich neuer Erfindungen, wie wir das anzunehmen geneigt sind. Nehmen wir doch einmal an, Thomas Edison wäre an einem Stromschlag gestorben, noch bevor er die Glühbirne erfunden hätte. Wäre die Geschichte dann völlig anders verlaufen? Nein, natürlich nicht. Laut einer von Robert Friedel, Paul Israel und Bernard Finn verfassten Geschichte der Glühbirne gebührt nicht weniger als 23 Personen das Verdienst, bereits vor Edison eine Version der Glühbirne erfunden zu haben.

Das Gleiche trifft so auch auf andere Erfindungen zu. Elisha Gray und Alexander Graham Bell meldeten an ein und demselben Tag ihr Patent auf das Telefon an. Als Google 1996 auf dem Markt erschien, existierte bereits eine ganze Reihe von Suchmaschinen. Wie Kevin Kelly in seinem Buch „What Technology Wants“ dokumentiert, sind allein sechs verschiedene Erfinder des Thermometers bekannt, drei der Injektionsnadel, vier der Impfung, fünf des elektrischen Telegrafen, vier der Fotografie, fünf des Dampfschiffes und sechs der elektrischen Eisenbahn. Die Geschichte der Erfindungen, schreibt der Historiker Alfred Kroeber, ist „eine nicht enden wollende Reihe von parallelen Vorgängen“. Das gilt für die Wissenschaft ebenso wie für die Technik. Das Boyle'sche Gesetz in den englischsprachigen Ländern unterscheidet sich nicht vom Mariotteschen Gesetz in den französischsprachigen Ländern. Isaac Newton machte seiner Wut über Gottfried Leibniz Luft, weil dieser zu Recht behauptete, er habe die Infinitesimalrechnung völlig eigenständig hervorgebracht. Charles Darwin wurde von Alfred Russel Wallace, der nach der Lektüre desselben Buches, nämlich des „An Essay on the Principle of Population“ von Malthus, genau dieselbe Idee hatte, dazu gedrängt, seine Theorie endlich zu veröffentlichen.

Die Technologie entwickelt immer stärker jene Art von Autonomie, wie sie bisher biologische Wesen auszeichnete. Der Stanford-Wirtschaftswissenschaftler Brian Arthur vertritt die Auffassung, dass sich die Technik selbst organisiert und sich in der Tat reproduzieren und an ihre Umgebung anpassen kann. Damit kann sie als ein lebender Organismus betrachtet werden, zumindest in dem Sinne, wie es sich bei einem Korallenriff um ein Lebewesen handelt. Natürlich könnte es ohne Tiere (sprich die Menschen), die sie schaffen und instand halten, nicht existieren. Doch das gilt auch für ein Korallenriff.

Es ist nicht abzusehen, wann dies auf die Technologie einmal nicht mehr zutreffen wird und diese sich selbstständig weiterentwickeln und unterhalten wird. Dem Wissenschaftsautor Kevin Kelly zufolge ist das „Technium“ – so bezeichnet er den sich entwickelnden Organismus, der sich aus unserem kollektiven Maschinenpark zusammensetzt – schon jetzt „ein sehr komplexes Wesen, das vielfach seinen eigenen Trieben folgt“. Es „strebt nach dem, was jedes lebende System anstrebt: die eigene Selbsterhaltung“.

Bereits im Jahr 2010 verfügte das Internet über etwa genauso viele Hyperlinks wie das Gehirn an Synapsen aufweist. Heutzutage stammt ein beträchtlicher Teil der Internetkommunikation nicht mehr von Menschen, sondern von Programmen. Diese dienen der Überwachung, dem algorithmischen Finanzhandel sowie weiteren Aufgaben. Schon heute ist es praktisch unmöglich, das Internet einfach abzuschalten.

Die Auswirkungen dieser neuen Sichtweise auf die Technologie – nämlich als ein eigenständiges Gebilde, das sich unabhängig davon, wer die Kontrolle darüber hat, ständig weiterentwickelt – sind erschreckend. Die Menschen sind in diesem Prozess nur noch Befehlsempfänger. Statt die Innovationswellen anzutreiben, bleibt uns nichts anderes übrig, als sie zu reiten. Die Technologie wird ihre Entwickler selbst finden, und nicht umgekehrt. Abgesehen davon, dass wir die Hälfte der Bevölkerung aus dem Verkehr ziehen müssten, können wir nur wenig unternehmen, um diesen Prozess aufzuhalten – und selbst das muss nicht zwangsläufig funktionieren.

In der Tat ist die Geschichte der Technologieverbote in dieser Hinsicht äußerst aufschlussreich. So verboten etwa die Chinesen der Ming-Dynastie große Schiffe, die Japaner der Shōgunate die Feuerwaffen, die Italiener im Mittelalter die Seidenspinnerei und die US-Amerikaner in den 1920er Jahren den Alkohol. Solche Verbote können zwar über einen langen Zeitraum – im Falle der Chinesen und Japaner über drei Jahrhunderte – aufrechterhalten werden, doch irgendwann finden sie ihr Ende, vorausgesetzt, es herrscht Wettbewerb. In der Zwischenzeit entwickelten sich diese Technologien in anderen Teilen der Welt weiter.

Es ist heute unvorstellbar, dass die Softwareentwicklung zu einem Stillstand kommt. Selbst wenn die Vereinten Nationen versuchen sollten, ein Verbot der Softwareentwicklung durchzusetzen, würde es in irgendeinem Land der Welt immer noch Programmierer geben. Schon diese abstruse Vorstellung zeigt, worauf ich hinaus will.

Da ist es schon einfacher, die technologische Entwicklung im Zusammenhang mit umfangreicheren Technologien zu verbieten, für die große Investitionen und nationale Rechtsvorschriften erforderlich sind. Im Namen des „Vorsorgeprinzips“ hat zum Beispiel die Europäische Union zwei Jahrzehnte lang ziemlich erfolgreich ein De-facto-Verbot für die gentechnische Veränderung von Nutzpflanzen aufrechterhalten. Das Prinzip besagt hier, dass jede noch so geringe Möglichkeit eines Schadens die Entwicklung einer neuen Technologie verhindern muss. Doch auch hier besteht kaum die Aussicht, dass diese Technologien weltweit gestoppt werden können.

Und wenn sich die Technologie schon in ihrem Fortschritt nicht aufhalten lässt, dann lässt sie sich wahrscheinlich ebenso wenig lenken. Um es mit den Worten von Herrn Kelly auszudrücken: „Das Technium verlangt nach dem, was mit der Evolution begonnen hat“. Die technologische Weiterentwicklung stellt ein weitaus spontaneres Phänomen dar, als es uns bewusst ist. Schluss mit der heroischen und revolutionären Geschichte vom Erfinder, hin zum unaufhaltsamen, schrittweisen und zwangsläufigen Fortschreiten der Innovation.

Zeitgleiche Entdeckungen und Erfindungen haben zur Folge, dass es sich bei der Vergabe von Patenten als auch bei der Verleihung von Nobelpreisen im Grunde genommen um ungerechte Entscheidungen handelt. Und in der Tat kommt es nur selten vor, dass die Verleihung eines Nobelpreises nicht auch eine Reihe von zutiefst enttäuschten Menschen hinterlässt, die dazu auch allen Grund haben.

Durch die Vergabe von Patenten als auch von Urheberrechten werden dem Einzelnen Anerkennung und Verdienst in einem viel zu hohen Maße entgegengebracht, und es wird der Eindruck erweckt, als würde sich die Technologie sprunghaft weiterentwickeln. Es sei daran erinnert, dass der ursprüngliche Grund für die Erteilung von Patenten nicht darin bestand, den Erfindern eine Belohnung in Gestalt der Erlangung von Monopolprofiten zukommen zu lassen, sondern sie dazu zu ermutigen, ihre Erfindungen einer breiten Öffentlichkeit zur Verfügung zu stellen. Um dies zu erreichen, ist das Recht auf geistiges Eigentum in gewissem Umfang zweifellos erforderlich. Doch mittlerweile ist man dabei viel zu weit gegangen. Heutzutage geht es bei den meisten Patenten weniger um den Austausch von Ideen als vielmehr um die Verteidigung von Monopolen und die Abschreckung von Wettbewerbern. Auf diese Weise wird Innovation verhindert.

Nicht einmal die aussagekräftigste Publikation bzw. Patentschrift liefert auch nur annähernd ausreichend Informationen, um einen Dritten in die Lage zu versetzen, seinen Weg durch das Gewirr aus denkbaren Experimenten zu finden. So hat beispielsweise eine Studie über Laser ergeben, dass die Baupläne und die schriftlichen Beschreibungen nicht dazu geeignet sind, um andere dabei anzuleiten, ein bestimmtes Laserdesign zu replizieren: Um dazu in der Lage zu sein, war man darauf angewiesen, mit den Erfindern zu sprechen. Somit führt ein Patent häufig nicht zu jener Transparenz, die eigentlich angestrebt wird, sondern behindert stattdessen den Fortschritt.

In den 1970er Jahren hat der Wirtschaftswissenschaftler Edwin Mansfield von der University of Pennsylvania eine Untersuchung zur Entwicklung von 48 elektronischen, chemischen, pharmazeutischen und maschinellen Erzeugnissen jener Zeit in den Bundesstaaten Neuenglands durchgeführt. Hierbei hat er festgestellt, dass das Kopieren von Produkten im Durchschnitt 65 % der Kosten und 70 % der Zeit erfordert, die für ihre Erfindung erforderlich gewesen wären. Und das bei Experten ihres Fachgebietes. Also würden die Unternehmen selbst bei völliger Freiheit in Sachen Kopieren auch weiterhin eher den Weg beschreiten wollen, Neues zu schaffen. Die Unternehmen befassen sich mit Grundlagenforschung aus dem Wissen heraus, dass sie auf diese Weise in der Lage sind, sich implizites Wissen anzueignen, das wiederum zu weiteren Innovationen führt.

In der Politik herrscht die Ansicht vor, dass man Innovationen gleich einem Wasserhahn einfach auf- und wieder zudrehen könne: Den Ausgangspunkt bilden pure wissenschaftliche Erkenntnisse, welche dann in angewandte Wissenschaft umgesetzt werden, die wiederum zu nützlicher Technologie weiterentwickelt wird. Daher ist es die Aufgabe eines patriotisch eingestellten Politikers, dafür zu sorgen, dass die Wissenschaftler in der obersten Etage ihres Elfenbeinturms ausreichend mit Finanzmitteln bedacht werden – und siehe da, aus dem Rohr am Fuße des Turms sprudelt die Technologie nur so heraus.

Dieses lineare Denkmodell darüber, wie Wissenschaft die Innovation und den Wohlstand vorantreibt, geht auf Francis Bacon zurück – jenen Philosophen und Staatsmann aus dem frühen 17. Jahrhundert, der England dazu drängte, mit den Portugiesen in Sachen Wissenschaftsnutzung gleichzuziehen, um auf diesem Wege Entdeckungen und wirtschaftliche Gewinne zu erzielen. Prinz Heinrich der Seefahrer hatte bereits im 15. Jahrhundert massiv in die Erstellung von Karten, in die Nautik und die Navigation investiert, was die Erkundung Afrikas und große Handelsgewinne zur Folge hatte. Und genau das war es, was Bacon nachzuahmen gedachte.

Jüngere Forschungen haben diese Geschichte jedoch als Mythos entlarvt, genauer gesagt als ein Stück Propaganda aus dem Hause Prinz Heinrich. So wie die meisten Innovationen resultierten auch Portugals navigatorische Fortschritte aus dem Experimentieren der Seeleute über Versuch und Irrtum und nicht aus den Mutmaßungen einiger Astronomen oder Kartografen. Angetrieben wurden die Wissenschaftler da schon eher durch die Erfordernisse, mit denen sich die Forschungsreisenden konfrontiert sahen, als andersherum.

Terence Kealey, ein Biochemiker, der sich zum Wirtschaftswissenschaftler weiterentwickelt hat, verdeutlicht mit dieser Geschichte, dass das in der Welt von Wissenschaft und Politik vorherrschende lineare Dogma, wonach die Wissenschaft die Innovation vorantreibt, welche wiederum den Handel ankurbelt, im Wesentlichen nicht zutrifft. Es verkennt, wo der Ursprung von Innovation liegt. Tatsächlich verläuft die Sache im Allgemeinen in entgegengesetzter Richtung.

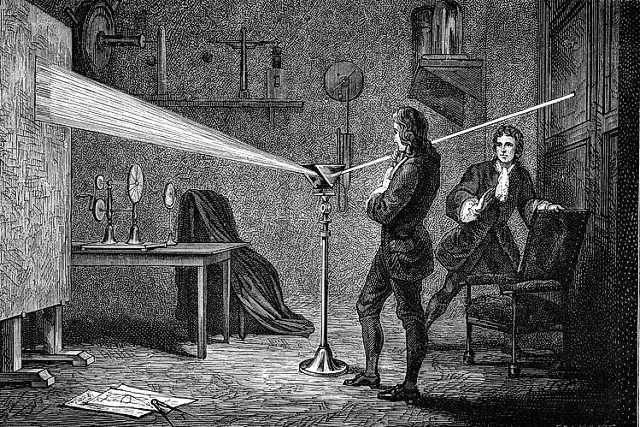

Untersucht man die Geschichte der Innovation, so zeigt sich immer wieder, dass bahnbrechende wissenschaftliche Erkenntnisse sich als Folge des technologischen Fortschritts ergeben haben und nicht als dessen Ursache. So ist es kein Zufall, dass die Astronomie im Gefolge des Entdeckungszeitalters eine Blütezeit erlebte. Auch die Dampfmaschine hat der Thermodynamik so gut wie nichts zu verdanken, die Thermodynamik der Dampfmaschine hingegen fast alles. Selbst die Entschlüsselung der DNA-Struktur beruhte maßgeblich auf der Röntgenkristallographie von biologischen Molekülen – eine Technik, die einst in der Wollindustrie eingeführt wurde, um die Qualität von Stoffen zu erhöhen.

Der technologische Fortschritt wird von Praktikern vorangetrieben – von Menschen, die so lange friemeln, bis sie die perfekten Maschinen entwickelt haben. Und abstrakte wissenschaftliche Überlegungen zählen zu den letzten Dingen, die sie anstellen. So berichtet Adam Smith in seinem Buch „The Wealth of Nations“ (Der Wohlstand der Nationen), nachdem er sich in den Fabriken im Schottland des 18. Jahrhunderts umgesehen hatte: „Ein großer Teil der in den Manufakturen verwendeten Maschinen ... war ursprünglich die Erfindung gewöhnlicher Arbeiter“, und viele Verbesserungen seien „durch den Einfallsreichtum der Maschinenbauer“ erzielt worden. Daraus folgt, dass die Wissenschaft weit weniger von der Regierung finanziert werden muss: Die Industrie selbst wird diese Aufgabe übernehmen. Wenn sie Innovationen hervorgebracht hat, wird sie auch für die Erforschung der ihnen zugrunde liegenden Prinzipien sorgen. Nachdem sie die Dampfmaschine erfunden hat, wird sie wohl auch für die Thermodynamik aufkommen. Diese Schlussfolgerungen von Herrn Kealey sind derart ketzerisch, dass sie den meisten Wirtschaftswissenschaftlern unverständlich bleiben, ganz zu schweigen von den Wissenschaftlern selbst.

Seit nunmehr einem halben Jahrhundert ist es fester Glaubensgrundsatz, dass eine Finanzierung der Wissenschaft nicht zustande kommt, wenn der Staat nicht dafür sorgt, und dass es kein Wirtschaftswachstum gibt, wenn die Wissenschaft nicht vom Steuerzahler finanziert wird. Es war der Wirtschaftswissenschaftler Robert Solow, der im Jahr 1957 den Nachweis erbrachte, dass es die technologischen Innovationen sind, aus denen das meiste Wirtschaftswachstum resultiert – zumindest gelte dies für Gesellschaften, die ihr Territorium nicht erweitern oder ihre Bevölkerung nicht vergrößern. Seine Kollegen Richard Nelson und Kenneth Arrow erklärten in den Jahren 1959 bzw. 1962, dass eine staatliche Finanzierung der Wissenschaft notwendig ist, da es billiger sei, andere zu kopieren als eine eigene Forschung zu betreiben.

„Das Problem mit den Arbeiten von Nelson und Arrow“, schreibt Kealey, „besteht darin, dass sie theoretischer Natur sind, und ein oder zwei unruhige Seelen, die über ihren wirtschaftswissenschaftlichen Tellerrand hinausblickten, festgestellt haben, dass es in der realen Welt anscheinend doch auch eine privat finanzierte Forschung gibt.“ Nach seiner Meinung gibt es immer noch keinen empirischen Beweis für die Notwendigkeit einer staatlichen Finanzierung der Forschung, obwohl die historische Entwicklung das Gegenteil belegt.

Ende des 19. und Anfang des 20. Jahrhunderts leisteten die USA und Großbritannien mit öffentlichen Mitteln in vernachlässigbarem Umfang enorme Beiträge zur Wissenschaft, während Deutschland und Frankreich mit beträchtlichen öffentlichen Mitteln weder in der Wissenschaft noch in der Wirtschaft zu besseren Ergebnissen gelangten. Nach dem Zweiten Weltkrieg begannen die USA und Großbritannien, die Wissenschaft in großem Umfang aus öffentlichen Mitteln zu finanzieren. Angesichts des Erfolgs der Kriegswissenschaft und der sowjetischen Staatsfinanzierung, die schließlich den Sputnik hervorgebracht hatte, schien es offensichtlich, dass die staatliche Finanzierung den entscheidenden Unterschied ausmachen würde.

Die wahre Lehre – wonach der Sputnik in hohem Maße auf der Arbeit von Robert Goddard beruhte, welche von den Guggenheims finanziert worden war – hätte auch in die andere Richtung ausgehen können. Doch für Großbritannien und Amerika brachte dieser Ansturm auf die Forschungsgelder keine Dividende in Form von Wachstum. Ihre Volkswirtschaften wuchsen nicht schneller als zuvor.

Im Jahr 2003 veröffentlichte die Organisation für wirtschaftliche Zusammenarbeit und Entwicklung ein Papier über „Die Quellen wirtschaftlichen Wachstums in den OECD-Ländern“ in den Jahren 1971 bis 1998 und stellte zu ihrer Überraschung fest, dass privat finanzierte Forschung und Entwicklung zu einem Anstieg des Wirtschaftswachstums führten, während die öffentlich finanzierte Forschung keinerlei wirtschaftliche Auswirkungen hatte. Überhaupt keine. Dieses erschütternde Ergebnis wurde nie in Frage gestellt oder gar entkräftet. Für das Argument, nach dem die Wissenschaft auf öffentliche Mittel angewiesen ist, erscheint dies derart unvorteilhaft, dass es einfach ignoriert wird.

Im Jahr 2007 kam der Wirtschaftswissenschaftler Leo Sveikauskas vom U. S. Bureau of Labor Statistics zu dem Schluss, dass die Erträge vieler Formen öffentlich finanzierter Forschung und Entwicklung gegen Null gehen und dass „viele Elemente der universitären und staatlichen Forschung nur sehr geringe Erträge erbringen und überwiegend nur indirekt, wenn überhaupt, zum Wirtschaftswachstum beitragen.“

Die Erklärung für diese Diskrepanz besteht nach Ansicht des Wirtschaftswissenschaftlers Walter Park von der American University in Washington, D. C., darin, dass die staatliche Finanzierung von Forschung die private Finanzierung weitgehend verdrängt. Das bedeutet, dass die Ausgabe von staatlichen Geldern für das falsche Wissenschaftsgebiet die Forscher davon abhält, am richtigen Forschungsgegenstand zu arbeiten.

Für die meisten Menschen beruht das Argument für eine öffentliche Finanzierung von Wissenschaft auf einer Reihe von Entdeckungen, die dank öffentlicher Mittel erzielt wurden, angefangen beim Internet (im Rahmen der Verteidigungsforschung der USA) bis hin zum Higgs-Boson (im Bereich der Teilchenphysik am CERN in der Schweiz). Doch das ist in höchstem Maße irreführend. Angesichts der Tatsache, dass die Regierung die Wissenschaft großzügig aus ihren enormen Steuereinnahmen finanziert hat, wäre es schon verwunderlich, wenn diese nicht zu irgendeiner Entdeckung gekommen wäre. Dies lässt jedenfalls keine Rückschlüsse darauf zu, was mittels alternativer Finanzierungsmodelle hätte entdeckt werden können.

Außerdem wird man nie erfahren, welche Entdeckungen nicht gemacht wurden, weil die staatliche Finanzierung sowohl die philanthropische als auch die kommerzielle Finanzierung verdrängt hat, die möglicherweise ganz andere Prioritäten gesetzt hätten. In einer solchen von Alternativen geprägten Welt ist es höchst unwahrscheinlich, dass die großen Fragen über das Leben, das Universum und das Bewusstsein zugunsten einer Frage vernachlässigt worden wären, die sich beispielsweise damit befasst, wie die Haustiere reicher Leute geklont werden können.

Eine Maschine der fortwährenden Innovation, welche das Wirtschaftswachstum ankurbelt und Wohlstand schafft, kommt nicht als das Ergebnis einer zielgerichteten Politik zustande, es sei denn in einem negativen Sinne. Entdeckungen als auch Erfindungen können von den Regierungen nicht angeordnet werden. Diese können lediglich sicherstellen, dass beide von ihnen nicht behindert werden. Innovation ergibt sich ganz von selbst aus der Art und Weise, wie Menschen in freier Entscheidung zusammenwirken, wenn sie nur die Möglichkeit dazu erhalten. Tiefgreifende wissenschaftliche Einsichten bilden daher jene Früchte, welche vom Baum des Technologiewandels fallen.